Il boom dei data center si riscalda

Di Bernard Lee

L'aumento della temperatura operativa dei Data Center influisce sull'affidabilità della fibra ottica

Big Data Analytics, Cloud, Internet of Thing: le parole d'ordine del settore ICT (Information and Communications Technology). Tutto ciò alimenta il fiorente mercato dei Data Center in tutto il mondo a un ritmo allarmante. Cisco ha previsto che entro il 2018 più di tre quarti (78%) dei carichi di lavoro saranno elaborati da data center cloud, mentre il 22% sarà elaborato da data center tradizionali. Anche se i carichi di lavoro complessivi dei data center quasi raddoppieranno (1,9 volte) dal 2013 al 2018, i carichi di lavoro del cloud quasi triplicheranno (2,9 volte) nello stesso periodo. La densità del carico di lavoro (cioè i carichi di lavoro per server fisico) per i data center cloud era di 5,2 nel 2013 e crescerà a 7,5 entro il 2018.

Le grandi opportunità sono accompagnate da grandi sfide. Quando si chiede a un operatore di Data Center "Qual è la sfida più impegnativa nella gestione del Data Center?", tutti rispondono senza dubbio che è il costo associato al sistema HVAC (Umidità, Ventilazione e Condizionamento) del Data Center. In molti Data Center, i costi annuali associati al sistema HVAC ammontano a milioni di dollari e, con l'aumento del costo dell'energia, questa è la voce più importante che molti operatori di Data Center vorrebbero vedere ridotta. Ma perché l'HVAC è così costoso nei Data Center? Storicamente, i data center hanno utilizzato il raffreddamento di precisione per controllare strettamente l'ambiente all'interno del data center entro limiti rigorosi 24 ore su 24, basandosi su pratiche che risalgono agli anni '50. Tuttavia, l'aumento dei costi dell'energia e l'imminente tassazione sulle emissioni di anidride carbonica stanno inducendo molte organizzazioni a riesaminare l'efficienza energetica dei data center e i presupposti alla base delle loro attuali pratiche. Da qui la domanda: "È necessario che i data center siano sempre così freddi?".

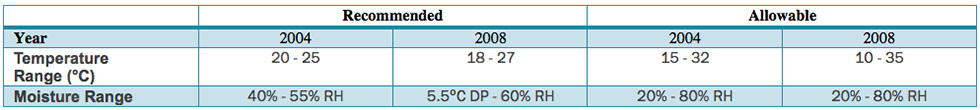

Nel corso del tempo, l'industria informatica ha lavorato su nuove innovazioni per ampliare gli intervalli termici e di umidità accettabili. È opinione diffusa che il funzionamento a temperature superiori alle condizioni di lavoro tipiche possa avere un impatto negativo sull'affidabilità dei sistemi elettronici ed elettrici. Tuttavia, l'effetto delle condizioni ambientali di funzionamento sull'affidabilità e sulla durata dei sistemi IT è stato poco compreso dagli operatori e dagli utenti IT. L'uso di un involucro ambientale meno rigido porterà a una potenziale riduzione di alcuni dei costi operativi associati ai sistemi HVAC di un data center. In particolare, i data center che non necessitano di un impianto di raffreddamento meccanico basato su refrigeratori e si affidano agli economizzatori possono risultare significativamente meno costosi sia nella costruzione che nella gestione. Uno di questi metodi è l'uso della tecnologia di raffreddamento ad aria naturale, nota come "Airside Cooling". Qual è l'impatto sul risparmio? Il vicepresidente di Gartner, David Cappuccio, stima che l'aumento della temperatura di un grado può far risparmiare circa 3% di costi energetici su base mensile. Qual è la temperatura ideale senza compromettere l'affidabilità? A che temperatura possiamo far funzionare i dispositivi senza aumentare le possibilità di guasto? Per fornire indicazioni al settore delle strutture IT e dei data center, l'American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE) ha introdotto il suo primo documento di orientamento sui livelli di umidità e temperatura raccomandati nel 2004; nel 2008, questo documento è stato rivisto per riflettere i nuovi intervalli concordati, che sono mostrati nella Tabella 1.

Nella sua guida, ASHRAE ha definito due intervalli operativi: "Consigliato" e "Consentito". Il funzionamento nell'intervallo consigliato può garantire la massima affidabilità e durata del dispositivo, riducendo al contempo il consumo energetico, nella misura in cui le condizioni termiche e di umidità dell'ambiente influiscono su questi fattori. L'intervallo consentito consente il funzionamento delle apparecchiature IT con tolleranze più ampie, pur accettando alcuni "rischi potenziali di affidabilità" dovuti a scariche elettrostatiche (ESD), corrosione o guasti indotti dalla temperatura e bilanciando il potenziale aumento del consumo di energia IT che ne consegue. Ciononostante, nel settore molti fornitori supportano intervalli di temperatura e umidità più ampi dell'intervallo consentito dall'ASHRAE 2008. È importante notare che la guida ASHRAE 2008 rappresenta solo l'intersezione concordata tra i fornitori, che consente alle apparecchiature di più fornitori di funzionare effettivamente nello stesso data center con un unico regime operativo. Nel 2011, l'ASHRAE ha nuovamente aggiornato le sue linee guida per definire due ulteriori classi di funzionamento nei Data Center, fornendo ai fornitori e agli utenti definizioni operative con limiti di temperatura ammissibile più elevati, rispettivamente fino a 40°C e 45°C.

Una delle aziende che ha concentrato la propria attenzione sull'aumento della temperatura di esercizio è Google. Erik Teetzel, Energy Program Manager di Google, ha dichiarato: "Le indicazioni che diamo agli operatori dei data center sono di alzare il termostato". Spingendosi oltre i limiti della temperatura di esercizio consentita, Google gestisce il suo Data Center in Belgio dal 2008 senza alcun refrigeratore e utilizza il raffreddamento naturale dell'aria, dove in alcuni periodi dell'anno la temperatura può raggiungere i 35°C. Troppo caldo per le persone, ma le macchine continuano a funzionare bene. Studi condotti da Intel e Microsoft hanno dimostrato che la maggior parte dei server si adatta bene a temperature più elevate e all'aria esterna, attenuando i timori di un aumento dei tassi di guasto dell'hardware. In effetti, Dell ha recentemente dichiarato di voler garantire il funzionamento dei propri server in ambienti caldi fino a 45°C (115°F), ovvero ben 20°C in più rispetto alla temperatura operativa raccomandata dall'ASHRAE. L'adozione globale di temperature operative più elevate nei Data Center è quindi inevitabile.

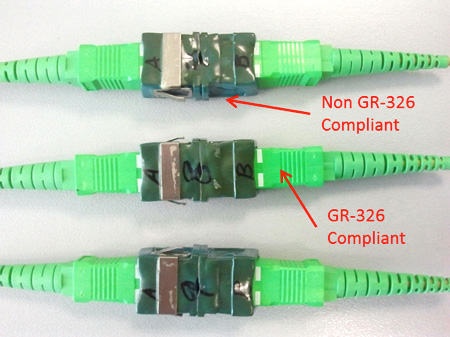

Figura 3 - Materiale inferiore allo standard non in grado di resistere ai test ambientali

Come si comporteranno le infrastrutture passive dei Data Center? La nuova temperatura operativa più elevata rappresenta una minaccia anche per l'affidabilità? Fortunatamente, la temperatura di esercizio di 45°C non è una novità per le infrastrutture passive e i fornitori di componenti affidabili hanno sempre eseguito test ad alte temperature di esercizio in conformità a standard internazionali come IEC 61753-1 e Telcordia GR-326-CORE. In alcuni regimi di test, l'affidabilità dei prodotti viene portata all'estremo sottoponendo i campioni a un invecchiamento termico accelerato per emulare una durata di servizio di circa 20 anni, una durata ragionevole per un'infrastruttura passiva poiché, a differenza delle apparecchiature attive che hanno una durata di servizio di circa 5 anni (e in alcuni casi anche più breve prima di essere sostituite da una versione più aggiornata), i componenti passivi come i cavi di collegamento, i cavi dorsali, i connettori e gli adattatori, nonché le canaline e i condotti per cavi non vengono sostituiti con la stessa frequenza. In alcuni casi, l'infrastruttura passiva è presente fin dall'inizio dell'attività del Data Center e viene sostituita solo perché non soddisfa le specifiche di prestazione richieste e non a causa di un guasto dei componenti (Figura 3). In sostanza, l'adozione di temperature operative più elevate nei Data Center è inevitabile, dobbiamo solo assicurarci che ciò che progettiamo e installiamo oggi sia pronto ad affrontare queste nuove sfide.